【论文翻译】AUTOACT: Automatic Agent Learning from Scratch via Self-Planning

【论文翻译】AUTOACT: Automatic Agent Learning from Scratch via Self-Planning

原文地址:AutoAct: Automatic Agent Learning from Scratch for QA via Self-Planning

摘要

语言模型智能体通过利用外部工具进行策略规划,在众多复杂的问答任务中展现出卓越的性能表现。然而,尽管在该研究领域不断深入探索,目前的语言模型智能体系统依旧难以摆脱对昂贵且难以复制的数据集的依赖,并且面临着如何使单一模型实现多功能的挑战。鉴于此,我们提出了一种名为AutoAct的自动化智能体学习框架,不依赖大规模的标注数据及闭源模型(如GPT-4)合成的计划路线即可用于问答任务。在有限的数据集和工具库条件下,AutoAct能够在无需人类或强大的闭源模型辅助的情况下,自动合成计划路线。接着,AutoAct采取分工合作策略,根据目标任务的具体信息和已合成的轨迹,自动进行区分并生成子智能体群体以完成相应任务。我们通过使用多种大型语言模型(LLM)进行了全面的实验验证,实验结果显示,AutoAct在与各类强大的基线方法相比时,能够取得更优或至少与之持平的性能。进一步的分析证实了分工策略的有效性,AutoAct所生成的轨迹质量通常优于其他方法。相关代码将于以下链接提供:https://github.com/zjunlp/AutoAct。

1 介绍

语言模型智能体通过利用大型语言模型(LLMs)卓越的推理能力,并与可执行工具进行交互,已成为构建用于处理复杂问答任务的人工智能系统的核心要素。将LLMs赋予此类交互功能的过程被称为智能体学习,其中规划环节扮演着至关重要的角色。规划环节负责将复杂问题拆解为更易处理的子问题,调用外部工具,反思历史错误,并从众多信息源中整合数据,以形成最终的答案。众多研究致力于直接推动闭源商业化的LLMs在特定任务上进行规划。尽管这些LLMs便捷且灵活,但它们不可避免地面临一些尚未解决的问题,如高昂的访问成本以及因其黑箱特性导致的结果难以复现。鉴于此,近期研究开始关注如何通过微调赋予开源模型规划能力。

然而,现有的基于微调方法虽然取得了一定的成果,但也存在明显的局限性。首先,训练开源模型需大量标注问答数据对,且仍依赖于闭源模型来完成规划轨迹的合成。在众多现实应用场景,如私人服务型机器人或企业敏感业务中,要满足这些条件往往面临重大挑战。其次,从智能体框架的视角来看,基于微调的方法要求单一语言模型智能体承担所有规划能力的训练,这对智能体而言是一个巨大的挑战。这一做法与Simon的有界理性原则相悖,该原则强调:“精细的社会分工和明确的个体任务可以弥补个体在信息处理与利用上的能力局限”。

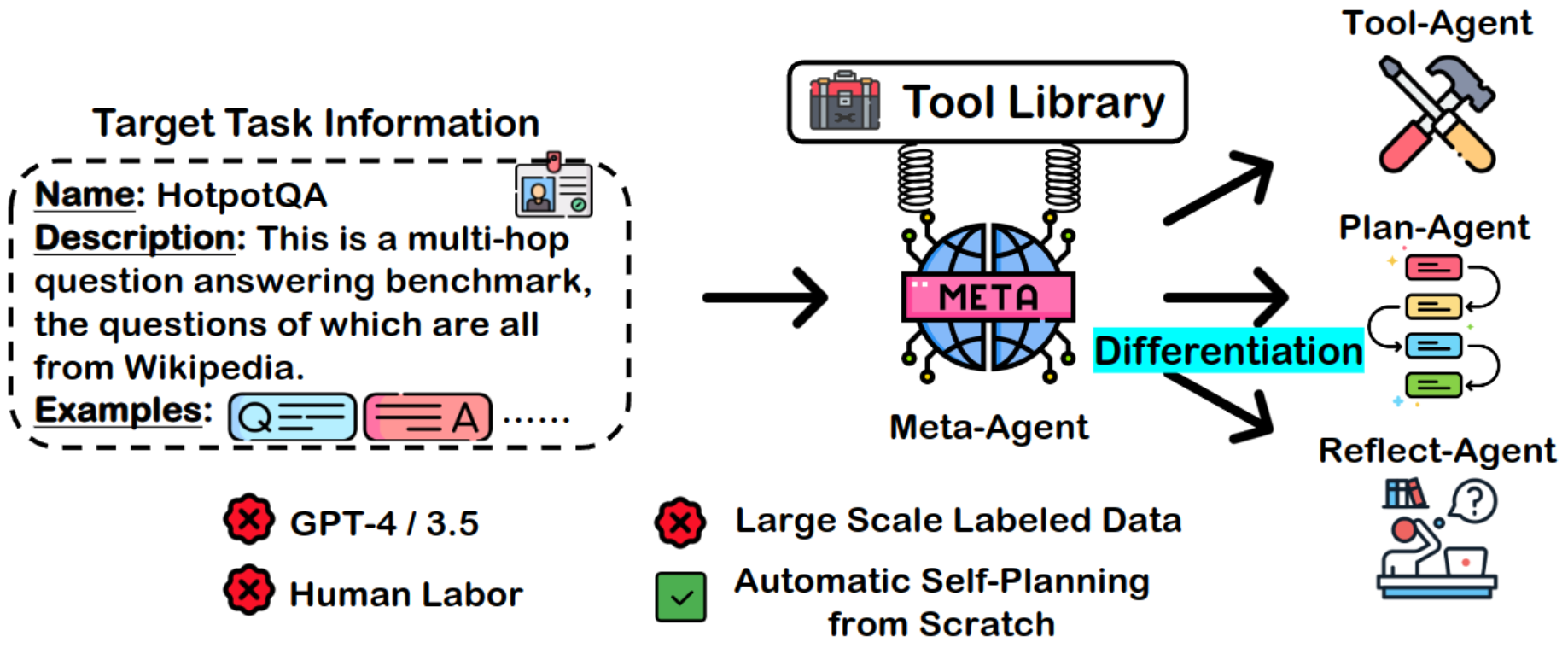

鉴于此,我们提出了AUTOACT,一个面向问答任务的自动化智能体学习框架。AUTOACT不依赖于大规模标注数据集和闭源模型生成的规划轨迹,而是采用明确的任务分工和精细的社会分工机制(见图1)。在用户提供的有限数据样本基础上,AUTOACT从META-AGENT出发,通过自我指导策略构建扩展的知识库。此外,借助预设的工具库,META-AGENT能够自主合成规划轨迹,无需人类干预或依赖强大的闭源模型。本研究进一步提出了一种基于自我合成轨迹(即“基因”)的分工策略,其过程类似于细胞分化的机制,其中META-AGENT充当干细胞,分化为三种不同功能的子智能体:任务分解智能体、工具调用智能体和自我反思智能体。这一分化过程实际上是一种在自我合成轨迹上的参数高效训练,具有较低的资源配置需求。表3详细展示了AUTOACT与先前研究工作的差异。

图1:展示了AUTOACT的基本架构。该系统仅依托一个工具库,便能使META-AGENT依据目标任务信息自动实现差异化,进而构建出一个能够协同作业以完成指定任务的子智能体群体。

在对多种大型语言模型(LLM)开展复杂问答任务的实验研究中,AUTOACT模型相较于众多强有力的基线模型展现出了更佳或至少持平的性能表现。广泛的实证分析进一步验证了我们所采用的合理分工策略之有效性。

2 AUTOACT

2.1 AUTOACT的关键组成部分

META-AGENT:META-AGENT(META-AGENT)承担着自我差异化前期的一切筹备工作,并为各个子智能体构筑基础模型框架。在掌握有限的任务目标信息及依托一个预先构建的工具库的前提下,META-AGENT能够裂变形成一个智能体群体,这些子智能体协同作业以实现既定任务目标。在AUTOACT框架内,META-AGENT得以采用任何形式的开源模型进行初始化。

目标任务信息:在本研究中,我们主要探讨从零开始的智能体学习问题,即所面临的任务信息极为有限,涵盖以下三个主要方面:任务名称\(\mathcal{M}\)、任务描述\(\mathcal{P}\)以及任务数据示例\(\mathcal{C}\)。具体而言,\(\mathcal{P}\)是对任务特性的详尽阐述。\(\mathcal{C}\)表示为\(\mathcal{C} = \{q_i, a_i\}^{|\mathcal{C}|}_{i=1}\),意指包含\(|\mathcal{C}|\)个问答示例对的集合,其中\(|\mathcal{C}|\)的规模较小,便于用户轻松提供,比如仅仅几个示范。有关任务信息的进一步细节,请参阅附录E。需注意的是,任务信息是AUTOACT在进行自动智能体学习时所依赖的唯一用户提供的任务知识来源。

工具库:为了提升智能体自动执行任务规划的能力,我们为其配备了一个完善的工具库,以便其调用。该工具库可表示为\(\mathcal{T} = \{m_i, d_i, u_i\}^{\mathcal{T}}_{i=1}\),其中\(m_i\)代表工具名称,\(d_i\)阐述了工具的功能,\(u_i\)则提供了工具的具体使用指南。符号 \(|\mathcal{T}|\) 表示工具库中工具的总数。在我们的自动系统中,原智能体拥有自主选择权,能够依据任务信息在工具库中选取适当的工具。用户亦可根据实际需求对工具库进行扩展,以实现更加灵活的任务处理。工具库的详细信息已在附录F中列出。

2.2 从头开始的自指导

为充分获取任务数据并供给充足的训练资源,本研究采取基于现有示例的数据增强策略。具体操作通过自我指导(self-instruct)机制实现。初始阶段,数据集\(\mathcal{D}\)初始化为与任务数据示例\(\mathcal{C}\)相等,并以\(\mathcal{C}\)作为数据生成的起始种子。在迭代过程中,META-AGENT利用随机从\(\mathcal{D}\)中抽取的少量样本提示,生成新的问答对。所生成数据经过筛选,去除格式错误与重复项后,被纳入\(\mathcal{D}\)中。经过若干轮次迭代,我们构建起一个包含丰富问答对的数据库\(\mathcal{D} = \{q_i, a_i\}^{|\mathcal{D}|}_{i=1}\),其中\(|\mathcal{D}|\)远大于\(|\mathcal{C}|\),表明数据量显著增加。本文所采用的自我指导提示详见于附录G.1,同时,附录H展示了部分自我指导生成的示例。

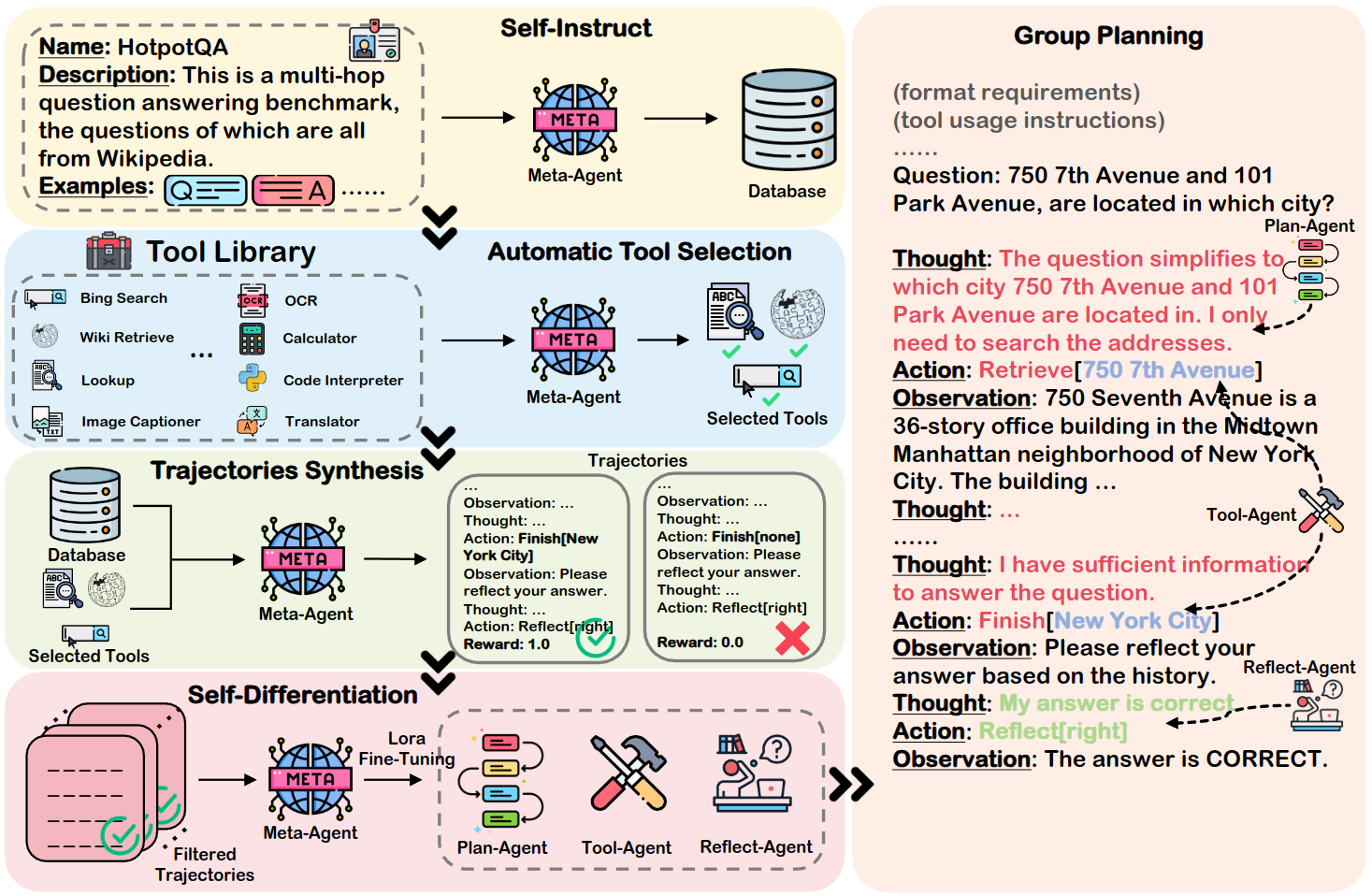

AUTOACT框架简要概述。本研究首先以自我指导为起点,着手从零构建任务数据库。接着,我们运用自我规划策略以实现智能体的自动化学习,内容涵盖自动工具选择、轨迹生成、自我分化以及群体协作规划。其中,自我分化环节是一种参数高效的微调机制,旨在促进资源优化的学习过程。

2.3 基于自我指导的智能体学习

自动工具选择

利用现有的工具库,我们实现了META-AGENT的自动化工具选择功能,使其能够针对每项任务自动匹配适宜的工具。具体而言,我们构建了一个工具列表\(\mathcal{T}\),其中包含了一系列工具,每个工具由三元组\(\{T = \{m_i, d_i, u_i\}\}\)表示,并将其作为prompt的一部分。此外,提示信息还包括对任务的描述\(\mathcal{C}\)。通过这种方式,我们指导META-AGENT从工具集\(\mathcal{T}\)中筛选出一组适合的工具子集\(T_s\)(\(T_s \subset T)\),以便在生成合成轨迹时使用。有关自动工具选择的详细prompt,请参见附录G.2。

轨迹合成

在摆脱闭源模型依赖的基础上,我们成功实现了META-AGENT自主规划轨迹的合成。通过集成\(T_s\),我们指导META-AGENT遵循Yao等人提出的思想-行动-观察范式,在数据库\(\mathcal{D}\)中采用零样本学习方法合成轨迹。为确保合成轨迹的高质量,我们对那些奖励值低于1的轨迹进行了筛选排除,并选取了奖励值为1的完整正确答案轨迹作为自我分化的训练素材。有关轨迹合成的具体prompt,详见附录G.3节。

自我分化

为了确立明确的职能分工,我们通过合成规划轨迹,将META-AGENT细分为三个承担不同职能的子智能体:

规划智能体\(\pi_{\mathrm{plan}}\),其主要职责是对问题进行分解,并依据公式2确定在每一轮规划迭代中应激活哪个工具。

工具智能体\(\pi_{\mathrm{tool}}\),负责具体工具的调用方式,通过决策工具调用所需的参数,如公式3所示。

反思智能体\(\pi_{\mathrm{reflect}}\),则负责进行反思活动,它通过综合分析历史轨迹,输出反思结果,具体过程如公式4所示。

我们假定在时刻\(t\)的计划循环可用三元组\((\tau_t,\alpha_t,\omicron_t)\)来描述,其中\(\tau\)代表思考,\(\alpha\)代表行动,而\(\omicron\)则指观察。行动\(\alpha\)可进一步细化为\((\alpha^m, \alpha^p)\),\(\alpha^m\)代表行动的名称,\(\alpha^p\)则表示执行该行动所需的具体参数。据此,时刻\(t\)的历史轨迹可以表述为: \[ \mathcal{H}=(\tau_0, \alpha_0, \omicron_0, ..., \tau_{t-1}, \alpha_{t-1}, \omicron_{t-1}). \tag{1} \] 最终,当我们将目标任务信息的提示、规划格式要求以及相关问题集成为一个整体\(\mathcal{S}\)时,可以据此明确界定每个子智能体的职责范围如下: \[ \begin{align} \tau_t, \alpha_t^m &= \pi_{\mathrm{plan}}(\mathcal{S}, \mathcal{T_s}, \mathcal{H}_t), \tag{2}\\ \alpha^{p}_{t} &= \pi_{\mathrm{tool}}(\mathcal{S}, \mathcal{T_s}, \mathcal{H}_t, \tau_{t}, \alpha^{m}_{t}),\tag{3}\\ \tau^r, \alpha^r &= \pi_{\mathrm{reflect}}(\mathcal{S}, \mathcal{T_s}, \mathcal{H}),\tag{4} \end{align} \] 其中\(\tau^r\)与\(\alpha^{r}\)分别表示反思的过程中的思考与行动两个维度,而 \(\mathcal{H}\) 则代表回答完成后的规划历史记录。依托于这些责任分配,我们能够重新梳理行为轨迹,并将其输入至META-AGENT系统中以实现自我分化。我们所采用的分化方式是一种参数效率极高的微调过程,旨在达成资源利用上的高效学习。具体而言,我们将在附录I中展示各个子智能体的训练数据示例。特别地,针对每一个子智能体,我们都训练了一个特别的LoRA。

群体计划

在推理过程中,当计划智能体(PLAN-AGENT)在时刻\(t\)调用生成的工具名称\(\alpha^m_t\)时,工具智能体(TOOL-AGENT)随即被激活,进而确定传递给相应工具的参数\(\alpha^p_t\)。该工具产生的输出结果被视为观察值\(\omicron_t\),并由计划智能体(PLAN-AGENT)进行后续处理。在计划智能体(PLAN-AGENT)与工具智能体(TOOL-AGENT)协同作用得出预测结果之后,反思智能体(REFLECT-AGENT)将对历史行为进行回顾与反思,输出包含于反思动作\(\alpha^r\)中的反思成果。若反思结果证实预测的准确性,则整个规划过程宣告完成;反之,计划智能体(PLAN-AGENT)与工具智能体(TOOL-AGENT)将依据反思信息继续开展规划工作。具体的群体规划流程可在图2右侧的示例中详查。

3 实验设置

任务和指标

我们在HotpotQA和ScienceQA对AUTOACT进行了评估。HotpotQA是一项具有挑战性的多跳问答任务,它要求参与者具备丰富的背景知识,其答案通常表现为一个简洁的实体或“是/否”判断。本项研究采用Liu等人的方法,从开发集中随机抽取了300个问题,按照难度划分为三个等级进行评估,每个等级包含100个问题。在HotpotQA任务中,我们定义奖励范围为[0, 1],该奖励基于预测答案与实际答案之间的F1分数进行等级评定。ScienceQA任务则是一个涉及众多科学领域知识的多模态问答任务。本研究将测试集划分为三个难度级别,并从每个级别中随机选取120个样本进行评估。鉴于ScienceQA任务的答案为多项选择题,\(\mathrm{reward}\in\{0, 1\}\),即正确率。需要指出的是,由于大型模型在图像生成方面的限制,在ScienceQA的自我指导阶段,我们仅生成图像标题,而不直接生成图像。

基线

本研究选取了开源Llama2模型以及Mistral-7B模型,作为META-AGENT及其子代理的核心。作为对照,我们选择了CoT、REACT、Chameleon、Reflexion、BOLAA、ReWOO以及FIREACT。具体的基线描述详见于附录B。为保障实验的公正性,我们保持FIREACT和AUTOACT的训练轨迹大小相同(即200个合成数据)。鉴于Reflexion模型在反思阶段提供了答案正确性的标签,而其他方法如AUTOACT则未提供此类标签,因此我们对其他所有方法进行了两次测试,并选取了表现正确的模型以进行评估。对于所有基于提示的基线模型,我们在提示中均统一提供了两个示例以供参考。

训练设置

本研究运用了LoRA方法对全部模型进行微调,使用Alpaca格式。所有训练及推理实验均在配备8块V100 GPU的硬件环境中执行,并在16小时内完成。具体的训练超参数设置已在附录B中予以详尽阐述。

4 结果

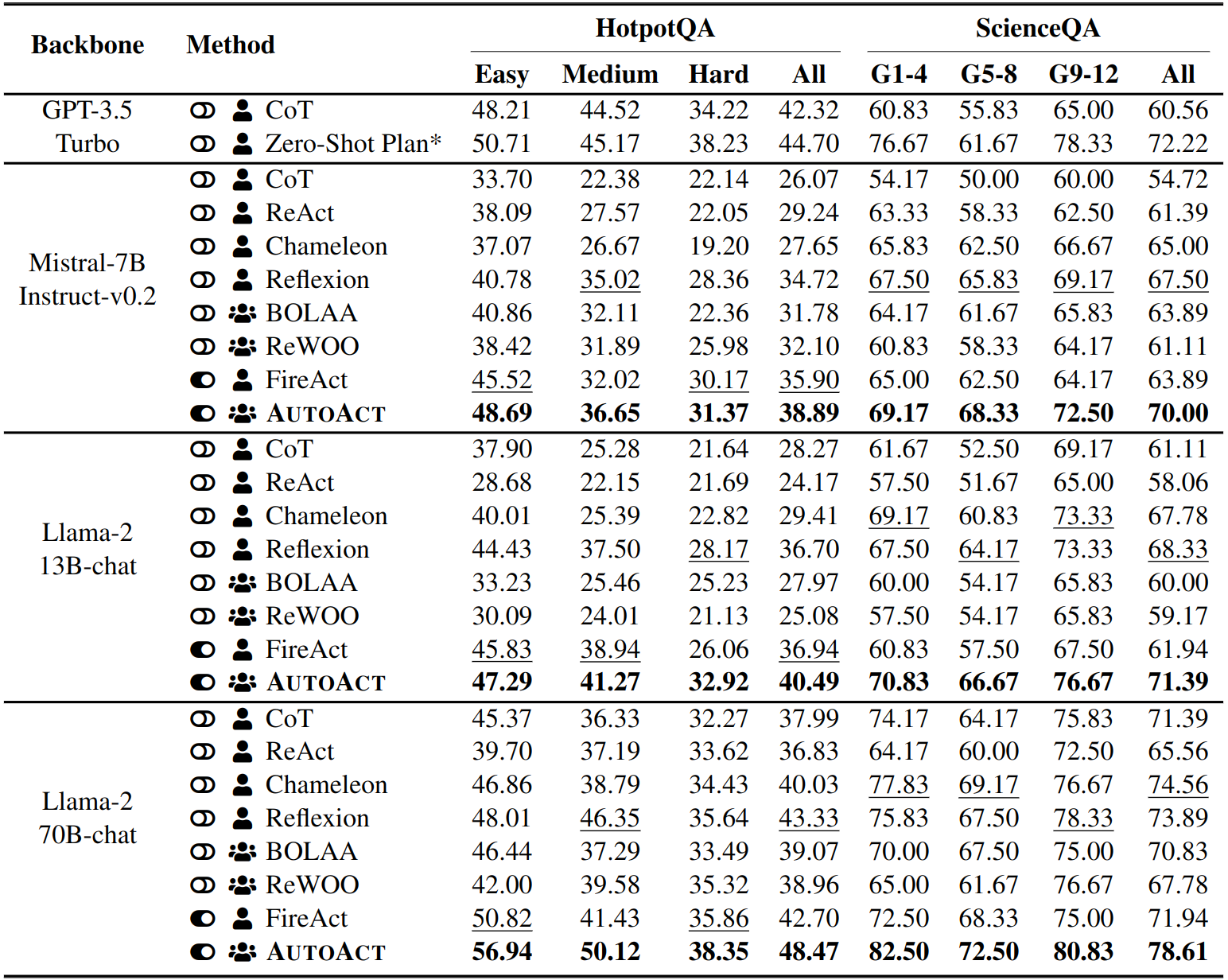

与基于Prompt的智能体基线对比

如表1所示,Mistral-7B与Llama-{13,70}B模型在各项指标上均超越了各类基于提示的基准模型。特别地,Llama-70B模型在智能体性能上甚至超越了GPT-3.5-Turbo,具体表现为在HotpotQA任务上提升了3.77%,在ScienceQA任务上提升了6.39%。由此可见,在单一智能体及多智能体架构中,基于少量示例的提示依赖型方法在精确定制智能体行为方面存在不足。此结论进一步得到了FIREACT在迭代规划场景下,相较于REACT和BOLAA具有更广泛优势的事实所支持。

与基于微调的智能体对比

进一步观察表1所展示的FIREACT,尽管借助了GPT-4的强大能力,FIREACT采取的将整个规划任务集中交由单一模型处理的策略,显然承受了巨大的压力。这一策略导致其在ScienceQA任务上的表现甚至不及采用提示式全局规划方法的Chameleon。相较之下,AUTOACT通过解耦规划过程,并在各个子智能体之间确立了清晰的职责分工,从而实现了更高效的团队规划。在HotpotQA任务中,采用Llama-70B模型的AUTOACT相较于FIREACT提升了5.77%,在ScienceQA任务上则提高了6.67%。此外,AUTOACT实现了不依赖闭源模型及大规模标注数据集的自我规划能力,这为利用开源模型从零开始进行自动智能体学习提供了可能。在后续的消融研究(第4节)和人工评估(第5节)中,我们将进一步证实AUTOACT所合成的轨迹质量,不低于经GPT-4训练的FIREACT所合成的轨迹质量。

表1:AUTOACT与其他不同基线方法在HotpotQA和ScienceQA任务中的主要对比结果。其中,“关闭图标”表示未进行微调的基于提示的智能体学习,而“打开图标”则代表进行了微调的智能体学习。“多人图标”用于表示多智能体学习,“单人图标”表示单一智能体学习。本文以粗体字标出各模型的最佳性能,并以下划线标注次佳表现。为了评估的公正性,本文将GPT-3.5-Turbo的零样本计划性能与本研究设置进行了比较,值得说明的是,本研究的设置并未包含带注释的轨迹示例。

单智能体学习对比多智能体学习

在相同的配置条件下,多智能体系统架构往往相较于单一智能体(例如REACT与BOLAA、FIREACT与AUTOACT的对比)展现出更优异的性能,这一现象与Simon关于有限理性的理论相符。表面上看似与常规预期相悖,Chameleon尽管采用单一智能体架构,却能在某些情况下超越BOLAA(甚至在ScienceQA测试中的FIREACT)。然而,经过我们的深入分析,这一优势可归结于其独特的工具利用策略。在Chameleon系统中,工具参数的决策过程被视为一次工具调用,并为该过程定制了专属的少量样本提示以引导模型。从这个视角来看,尽管Chameleon在名义上属于单一智能体架构,其实际表现却具备了多智能体架构的某些特征,这与我们之前的结论并不冲突。事实上,从优化目标的角度同样可以对此进行解释。著名的Goodhart定律(Goodhart,1984年)提出:“一旦某个指标成为目标,它便不再是一个好的指标。”这表明在单一智能体上对某一目标进行优化,不可避免地会在某种程度上对其他优化目标造成损害。因此,试图在单一智能体上同时优化所有目标并非最佳策略,而多智能体架构恰好能够有效解决这一问题。然而,我们在第5节的分析中指出,对工作分工进行过度细化也并非理想之选。

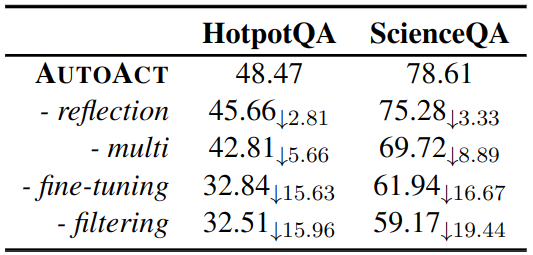

消融实验

表2:AUTOACT方法的消融分析。-reflection指的是在AUTOACT框架中去除反思智能体。-multi则表示将所有分散的数据集统一输入至单一模型中进行微调。-fine-tuning是指依据AUTOACT所设定的三个智能体执行零样本提示规划的过程。-filtering是指在零样本规划阶段,对所有生成的轨迹进行自我筛选,排除错误案例而不进行过滤处理。

表2详细展示了在剔除部分关键过程后,AUTOACT算法在Llama-70B模型上的性能变化情况。观察结果表明,移除- reflect过程对模型性能的影响最为微弱。本研究发现,在零样本条件下,模型倾向于对自身的回答表现出过度的自信,这一现象亦在Huang等人的研究中得到了验证。模型通常仅在规划过程中出现显著的格式错误或重大重复时,才能意识到自身的错误。与先前研究成果一致,移除“- multi”过程导致了性能的显著降低。更有意思的是,“- multi”过程的移除结果与FIREACT的表现不相上下,这从侧面暗示了70B模型生成的轨迹质量可能不低于GPT-4。如预期,去除“- fine-tuning”过程后,模型性能有所下降,从而再次印证了先前的结论。为了进一步验证过滤规划错误数据的重要性,本研究特别去除了过滤过程(- filtering),以观察AUTOACT的表现。研究结果显示,未经过滤的数据训练对模型性能的负面影响,甚至超过了去除“- fine-tuning”过程所造成的影响。

5 分析

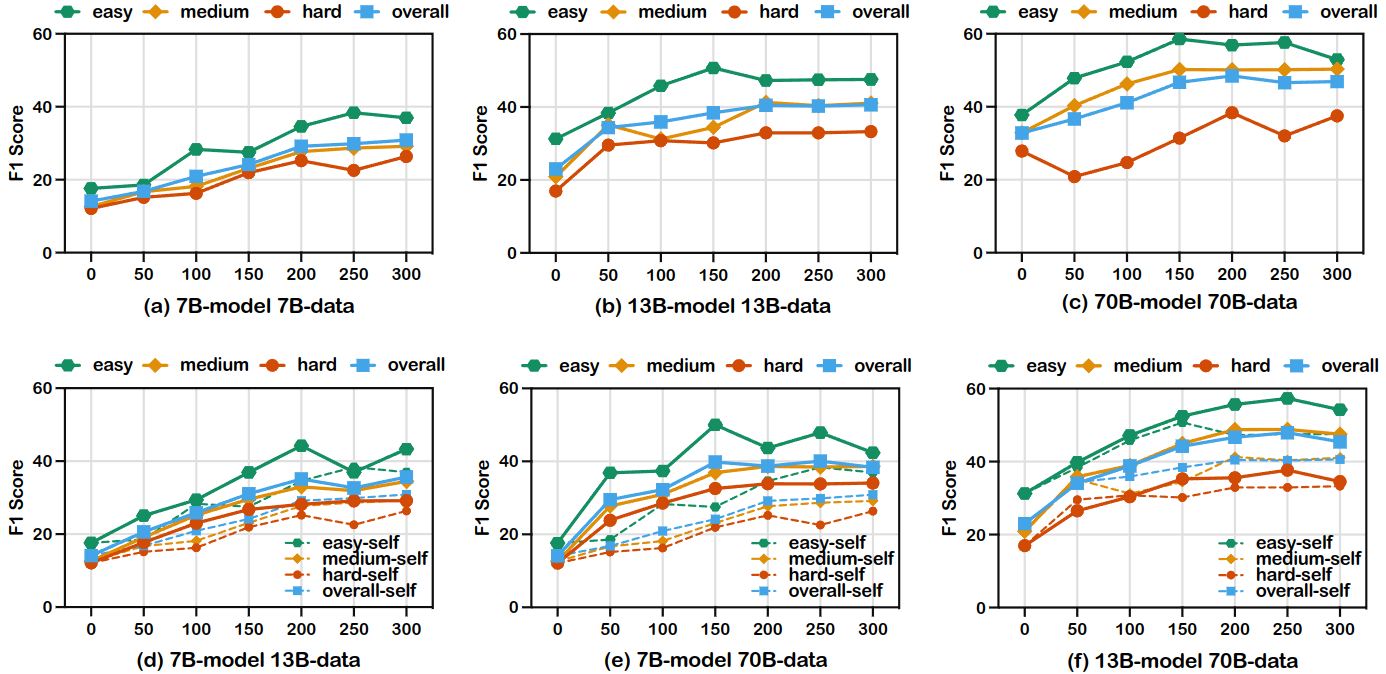

图3:随数据集规模的不同AUTOACT在HotpotQA上的表现。{7,13,70}B分别代表不同规模的Llama-2-{7,13,70}B聊天模型。(a-c)图展示了在自构建轨迹数据上训练的模型所取得的结果。(d-f)图则展示了在由更强大模型生成的轨迹数据上训练的模型成果,其中虚线代表在自合成轨迹数据上训练的基线模型。

数据越多不一定越好

图3(a-c)呈现了不同训练数据量对Llama-{7,13,70}B模型在HotpotQA任务中自我规划性能的影响。观察结果表明,当数据量增至200以上时,各模型的性能趋于稳定,且波动幅度最小。我们推测,这可能是因为简单的自我指导在提升语言模型内部知识方面具有局限性。随着训练数据量的增加,通过自我指导能够获取的知识量逐渐减少。尽管我们尽力筛选并移除重复数据,但数据量的无节制增加不可避免地导致相似数据比例的升高,这不仅削弱了扩大数据规模所带来的正面效应,而且使得提升模型性能的任务变得更加艰巨,甚至可能诱发过拟合现象。为了深入探究训练数据的作用,我们实施了将模型与训练数据解耦的实验,并评估了模型在由更大型模型生成的轨迹上的训练成效。如图3(d-f)所示,所得结果与先前的发现相吻合。因此,我们提出,最大化合成数据的多样性或许是AUTOACT方法的关键改进途径,这一方向将留待后续研究深入探讨。此外,从图3(d-e)的数据中我们还发现,模型规模越大,其合成的数据质量越高,这在7B模型在13B和70B模型合成数据上表现出的性能逐级提升趋势中得到了体现。

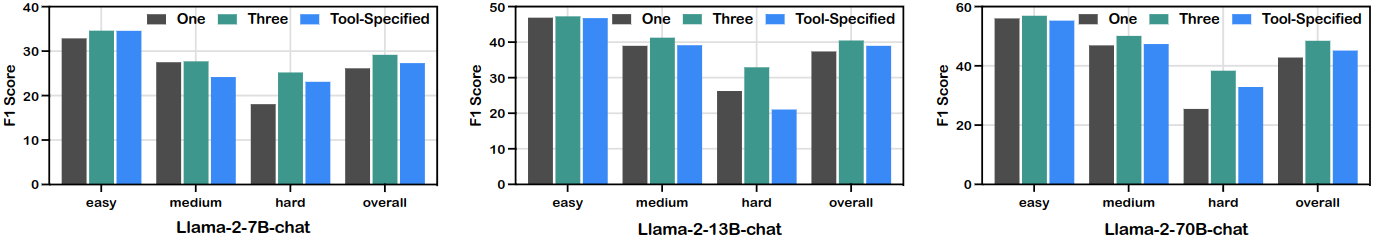

图4:采取不同级别的分工AUTOACT在HotpotQA上的表现。One是利用全部差异化数据对单一模型进行训练。Three表示分化为plan,tool,reflect三类智能体。ToolSpecified表示进一步细化,每一种工具使用一个智能体。

适当的分工有助于优化整体的表现

为深入探究自我差异化在差异粒度上的影响,我们对工具智能体进行了进一步的细化,为每种工具分配了专门的智能体。如图4所示,我们对比了单一智能体(One agent)、三智能体系统(Three agents,即AUTOACT)与工具指定设置(Tool-Specified setting)在Hot-potQA任务上的性能表现。观察结果表明,过度分化(工具指定设置)非但未能提升效果,有时甚至不如不进行分化(单一智能体)的表现。这一发现与Qiao等人的研究结论相吻合,他们指出多工具联合学习模式往往优于单工具独立学习策略。同时,相较于AUTOACT,工具特定智能体在处理更具挑战性的问题时性能损失更为明显。这是因为解决这类问题通常需要更多的规划环节以及工具之间更紧密的协作。通过将所有工具调用统一于单一智能体之下,可以有效学习工具间的相互关系,弥补由工具特定智能体带来的潜在信息缺失。值得注意的是,与Li等人的研究不同,本文讨论的是具有不同职责的智能体间的分工粒度问题,而非相互平等智能体间的投票数量。

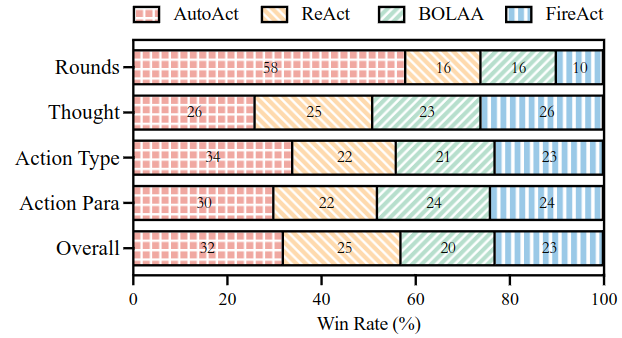

人类评估

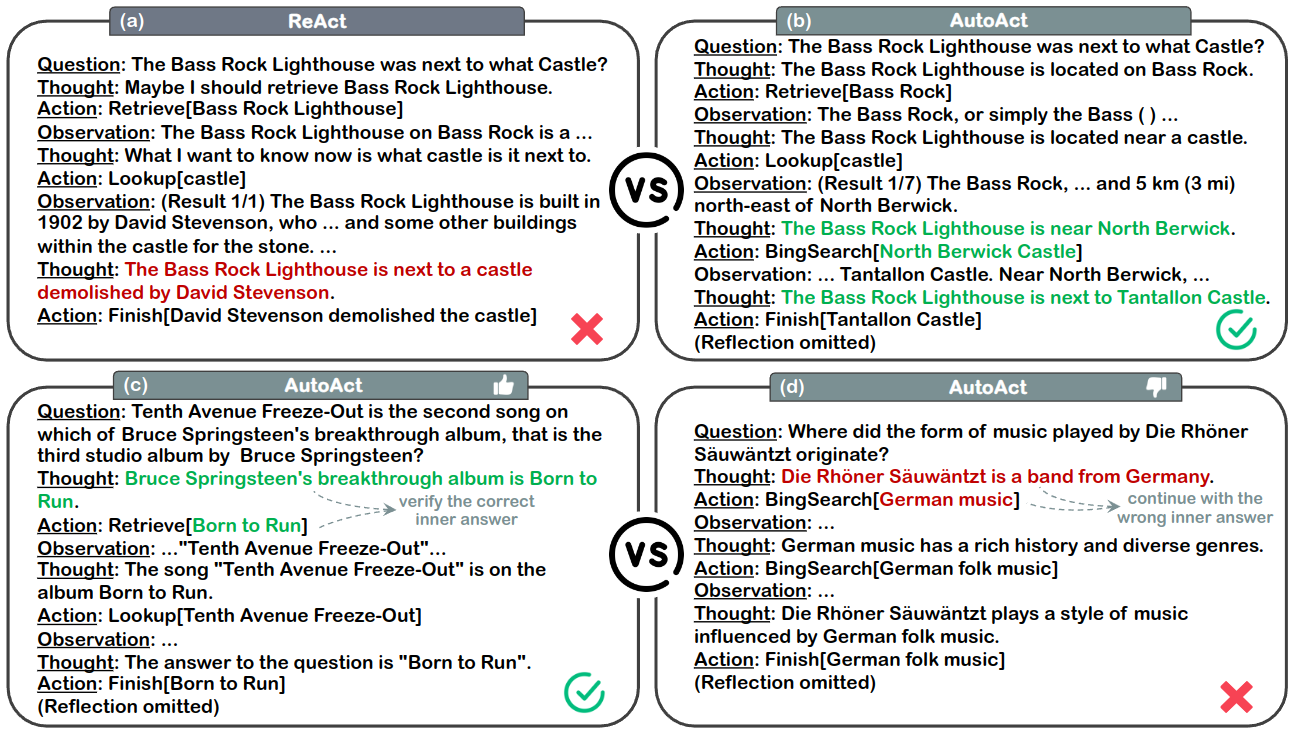

为深入探究不同方法产生的轨迹质量,本文从规划轮次数量、思维逻辑准确性、行为类别、行为参数及整体连贯性等多个维度对这些方法进行了细致的人工对比分析。具体的人工评估流程详述于附录C。评估结果在图5与图6中得以呈现。观察发现,在行为类别与行为参数方面,AUTOACT相较于其他方法展现了显著优势。这一现象说明,将规划任务与工具调用任务分离,有助于两者均实现性能提升,同时也减轻了单一智能体所承受的巨大压力。如图5(a-b)所示,AUTOACT通过采纳更合理的工具组合与更精确的工具调用,成功克服了REACT中存在的缺陷。此外,AUTOACT倾向于在规划轮次上投入更多(具体平均规划轮次数见附录D),这一特点使其在应对复杂问题时表现出色。然而,在处理简单问题时,这一特性可能反成为其劣势。值得注意的是,AUTOACT能够通过增加验证轮次来验证其内部答案(见图5(c)),但这也可能导致上下文过长,进而使AUTOACT逐渐偏离原始问题(见图5(d))。

图5:HotpotQA的样例分析。AUTOACT通过使用更科学的工具组合并做出更准确的工具调用成功解决了REACT(a)中出现的错误。随着规划轮次的增加,AUTOACT(c)能够通过持续的自我验证过程来进一步确认其内部的答案。然而,这一过程也可能导致上下文长度逐渐增加,进而使得AUTOACT(d)的回答逐步偏离了原始问题的核心。

图6:针对Llama-2-70B-chat在HotpotQA任务中所生成轨迹的人类评估分析。本研究对各类轨迹的规划轮数、思维逻辑准确性、行为类别、行为参数设置以及整体连贯性进行了详细对比。所附图表直观地反映了不同方法在各个评估维度上的胜率分布。

6 相关工作

略

7 结论和未来工作

在本研究中,我们构建了AUTOACT这一创新性框架,该框架能够实现在不依赖大规模标注数据及闭源模型的前提下,自动生成合成轨迹,进而辅助问答系统中的智能体学习。此外,通过明确分配工作负载,本框架有效缓解了单个智能体的压力。值得探索的研究方向包括:

- 将AUTOACT应用于更为实际的任务场景;

- 如第五节所述,通过自我指导机制引入更多知识;

- 利用自我提升的迭代策略强化合成轨迹的质量。

局限性

在本文研究中,我们致力于构建一种名为AUTOACT的自动化智能体学习框架。尽管我们竭尽所能,但不可避免的是,本文或许仍包含某些未尽的局限性。

任务

本文主要聚焦于复杂问题回答任务。然而,实际应用中存在众多更为复杂的交互场景,诸如网络环境、家庭场景、旅行规划以及机器人控制等。例如,我们已对在虚拟环境中利用META-AGENT进行随机探索以替代传统的自我指导和无样本规划的任务与轨迹生成过程进行了研究。未来,我们计划基于当前成果,将AUTOACT算法应用于更多类型的任务。

增强知识自我指导

正如第5节所述,AU-TOACT的规划性能可能会受到模型通过自我指导获取内部知识能力的限制。尽管当前方法在参数和数据层面实现了轻量级的自我区分,但在数据量有限的前提下,尽可能丰富模型知识仍至关重要。

自我提升

近期研究展示了通过在自我生成的数据集上迭代训练来提升大型语言模型(LLMs)性能的自我提升技术。该技术使得模型能够持续学习并优化其性能。我们的研究同样涉及在自我生成的数据上开展训练,我们相信通过进一步引入自我提升的迭代思考机制,将显著提升本方法的表现。

伦理声明

本研究恪守最高的伦理规范和研究优良传统。所有实验均采用公开可获取的数据库(具体详见第3节),从而规避了与隐私保护、保密原则以及个人生物信息不当使用相关的伦理风险。在人类评估环节(详见附录C),我们严格依照公平性及透明度原则进行操作。鉴于此,本研究未涉及任何伦理问题。